Дублирование мета-тегов и заголовков происходит на сайтах очень часто, что крайне негативно влияет на продвижение страниц.

Причины могут быть следующими:

- При создании сайта разработчики не уделили должного внимания автоматической генерации страниц.

- На сайте много похожих товаров или услуг с одинаковыми характеристиками.

- Одинаковые товары или услуги могут располагаться в разных категориях.

- Некорректная техническая оптимизация дублирующих страниц.

- На сайте генерируются динамические версии страниц с get-параметрами (после знака “?” в URL страницы).

Расскажем, как можно найти и исправить дубли в мета-тегах и заголовках и помочь сайту ускорить свой рост к топу.

Содержание

- Почему дубли мета-тегов и заголовков - плохо?

- Как найти страницы с дублями title, description или H1

- Как исправить дубли на сайте

Почему дубли мета-тегов и заголовков - плохо?

Поисковики сканируют ваш сайт и определяют содержимое его отдельных страниц в первую очередь по заголовкам. То, какое содержимое поисковой робот увидел на странице, будет определять запросы, по которым страница будет выходить в выдаче.

Если на вашем сайте будет две страницы для одного товара или услуги, ни одна из них не сможет получить хороших позиций в выдаче, так как роботы будут пытаться показывать их обе. Таким образом, какая-то одна из них не получит хорошую ссылочную массу и поведенческие показатели, необходимые для продвижения.

Даже если у вас нет проблем с полноценными копиями страниц, мета-теги могут дублироваться у разных страницах по тем или иным причинам: ошибка шаблонизации, автоматическое заполнение пустого поля, динамические параметры, человеческий фактор.

Наличие “ненужных” страниц на сайте также негативно влияет на его краулинговый бюджет - чем больше страниц на сайте, тем реже поисковые роботы смотрят “нужные” страницы.

Как найти страницы с дублями title, description или H1

Чтобы найти дубли, нужно просканировать все страницы сайта. Опишем три самых популярных варианта.

Screaming Frog SEO Spider

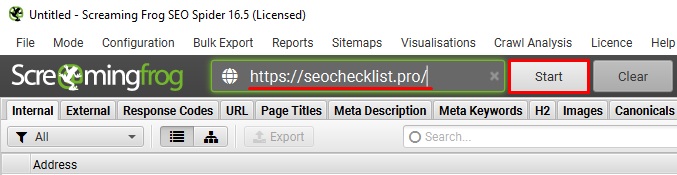

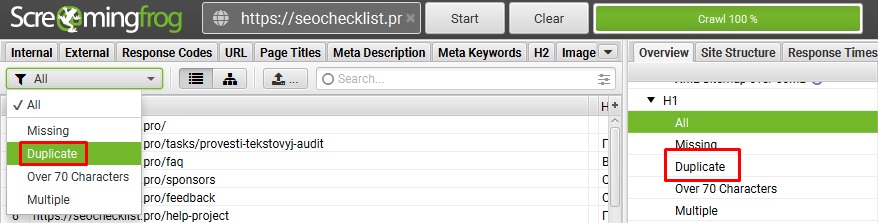

Для того, чтобы обнаружить страницы с дублями Title, Description или H1 в этой программе, необходимо:

- Запустить сбор информации;

- После окончания процесса открыть вкладки Page Titles, Meta Description и H1;

- Находясь на выбранной вкладке, выбрать пункт фильтра Duplicate. Страницы с дублями будут идти друг за другом.

Labrika

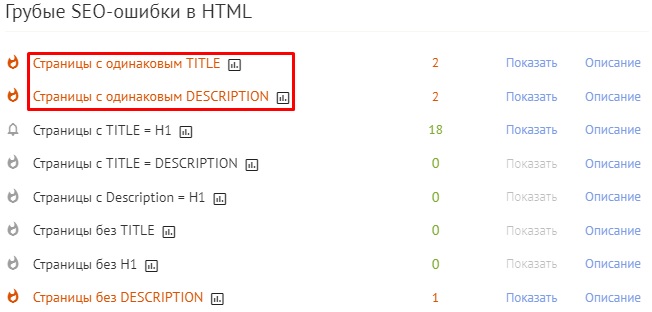

В Labrika вам нужно провести SEO-аудит вашего сайта. После окончания анализа откройте раздел Грубые SEO-ошибки в HTML:

Чтобы увидеть страницы с дублированием, нажмите Показать на соответствующих строках.

Яндекс.Вебмастер

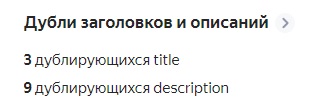

Сервис для вебмастеров от Яндекса может показать дубли мета-тегов Title и Description для тех страниц, которые находятся в индексе поисковой системы.

Обычно при наличии дублей информация о них появляется на главном экране проекта - Сводке:

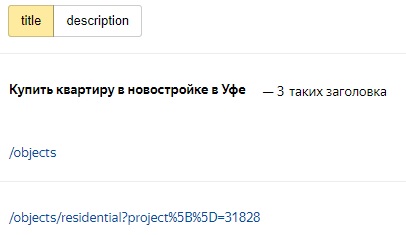

Если кликнуть на этот блок, можно перейти к детальному описанию дублей (информация находится в разделе Индексирование, вкладка Заголовки и описания). Там вы можете увидеть конкретнее, на каких страницах дублируются мета-теги:

Как исправить дубли на сайте

В зависимости от того, как именно дублируются страницы, есть несколько способов устранения проблемы:

- Изменение мета-тегов и заголовков в административной панели. Самый простой способ, который работает только в случае наличия доступа к настройкам всех необходимых страниц. Вам нужно просто зайти в настройки этих страниц и изменить повторяющиеся элементы. Данный способ подойдет в случае, когда у разных страниц установлены одинаковые мета-теги.

- Установка тега canonical. Этот тег показывает роботам, какая страница является “основной версией” страницы, на которой он указан. Подробно про этот тег мы рассказывали в этой инструкции. В данном случае исправляется дублирование тегов в разных версиях одной и той же страницы - с пагинацией, фильтрами, рекламными метками и т.д.

- Закрытие страниц от индексации. Если настроить страницы или поставить тег canonical нет возможности, стоит закрыть самые “неполезные” страницы с помощью тега noindex или файла robots.txt. Это крайняя мера, которую лучше использовать только в случае, если два первых способа не работают. Закрытые от индексации страницы не появятся в поиске, поэтому продвигать их будет невозможно.

Дублирование на сайте - всегда плохой признак. Вам необходимо постоянно следить за продвигаемыми страницами и устранять проблемы как можно скорее, иначе позиции будут падать все ниже, а восстанавливать их будет все сложнее.

Спасибо, что дочитали до конца. Переходите к следующей инструкции.